Dieser Artikel untersucht die Anwendbarkeit des AI Acts für Hersteller von Medizinprodukten und IVD, die keine KI-basierten Produkte in den Verkehr bringen.

Unter anderem beantwortet er die Frage, ob ein Hersteller den AI Act beachten muss, falls er ChatGPT verwendet oder zur eigenen Nutzung ein KI-System entwickelt, das Kundenrückmeldungen klassifiziert.

Dieses Dokument diskutiert nicht den Fall, dass die Betreiber gemäß Artikel 25 des AI-Act Herstellerpflichten übernehmen, beispielsweise weil sie das KI-System ändern.

Hersteller von KI-basierten Systemen sollten den „Haupt-Artikel“ zum AI-Act beachten.

1. Regulatorischer Rahmen

1.1 Scope / Anwendungsbereich

Der AI-Act definiert seinen „Scope“ (Anwendungsbereich) im Artikel 2:

Diese Verordnung gilt für

a) Anbieter, die in der Union KI-Systeme in Verkehr bringen oder in Betrieb nehmen oder KI-Modelle mit allgemeinem Verwendungszweck in Verkehr bringen, unabhängig davon, ob diese Anbieter in der Union oder in einem Drittland niedergelassen sind;

b) Betreiber von KI-Systemen, die ihren Sitz in der Union haben oder in der Union befinden;

Die Verordnung definiert auch den Begriff Betreiber:

eine natürliche oder juristische Person, Behörde, Einrichtung oder sonstige Stelle, die ein KI-System in eigener Verantwortung verwendet, es sei denn, das KI-System wird im Rahmen einer persönlichen und nicht beruflichen Tätigkeit verwendet;

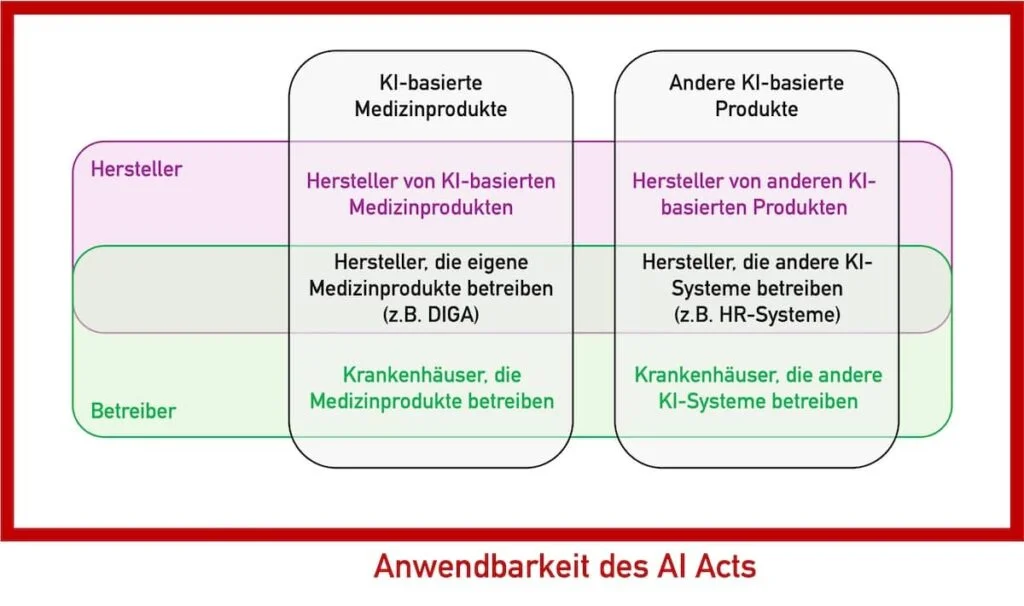

Die Anwendbarkeit des AI Act bezieht sich somit auf Anbieter (Hersteller) und Betreiber.

1.2 Hochrisiko-KI-Systeme

Als Hochrisiko-KI-Systeme zählen gemäß Artikel 6 Produkte, die KI-Systeme enthalten oder sind, welche

- ein Sicherheitsbauteil sind oder enthalten und damit die Gesundheit und die Sicherheit von Personen oder Eigentum gefährden

- in Anhang III genannt sind, es sei denn, sie stellen kein erhebliches Risiko dar.

Anhang III nennt u. a.:

- Biometrische Systeme

- Systeme für die allgemeine und berufliche Bildung, die über den Zugang zur Bildung entscheiden oder der Bewertung von Lernergebnissen oder des Bildungsniveaus dienen

- Systeme, die über die Auswahl, Einstellung, Beförderungen oder Beendigung von Arbeitsverhältnissen mitentscheiden

1.3 Übergangsfristen

Die Übergangsfristen für bereits in Betrieb genommene KI-Systeme regelt Artikel 111:

(2) Unbeschadet der Anwendung des Artikels 5 gemäß Artikel 113 Absatz 3 Buchstabe a gilt diese Verordnung für Betreiber von Hochrisiko-KI-Systemen — mit Ausnahme der in Absatz 1 des vorliegenden Artikels genannten Systeme —, die vor dem 2. August 2026 in Verkehr gebracht oder in Betrieb genommen wurden, nur dann, wenn diese Systeme danach in ihrer Konzeption erheblich verändert wurden. In jedem Fall treffen die Anbieter und Betreiber von Hochrisiko-KI-Systemen, die bestimmungsgemäß von Behörden verwendet werden sollen, die erforderlichen Maßnahmen für die Erfüllung der Anforderungen und Pflichten dieser Verordnung bis zum 2. August 2030.

2. Anforderungen

2.1 Anforderungen an die Kompetenz

Die Verordnung fordert im Artikel 4 die Kompetenz auch von den Betreibern:

Die Anbieter und Betreiber von KI-Systemen ergreifen Maßnahmen, um nach besten Kräften sicherzustellen, dass ihr Personal und andere Personen, die in ihrem Auftrag mit dem Betrieb und der Nutzung von KI-Systemen befasst sind, über ein ausreichendes Maß an KI-Kompetenz verfügen, wobei ihre technischen Kenntnisse, ihre Erfahrung, ihre Ausbildung und Schulung und der Kontext, in dem die KI-Systeme eingesetzt werden sollen, sowie die Personen oder Personengruppen, bei denen die KI-Systeme eingesetzt werden sollen, zu berücksichtigen sind.

Dabei definiert die Verordnung auch den Begriff „KI-Kompetenz“:

die Fähigkeiten, die Kenntnisse und das Verständnis, die es Anbietern, Betreibern und Betroffenen unter Berücksichtigung ihrer jeweiligen Rechte und Pflichten im Rahmen dieser Verordnung ermöglichen, KI-Systeme sachkundig einzusetzen sowie sich der Chancen und Risiken von KI und möglicher Schäden, die sie verursachen kann, bewusst zu werden.

2.2 Anforderungen an Betreiber von Hochrisiko-KI-Systemen

Der AI-Act (Artikel 26) verpflichtet die Betreiber von Hochrisiko-KI-Systemen zu Folgendem:

- System wie vom Hersteller bestimmt benutzen

- Kompetenz der Anwender sicherstellen

- System überwachen, auch menschliche Aufsicht leisten

- Protokolle aufbewahren

- Probleme melden (Hersteller, Behörden) (s. auch Artikel 73)

Zudem sind die Betreiber verpflichtet,

- eine Grundrechte-Folgenabschätzung zu machen (Artikel 27)

- sich zu registrieren (Artikel 49) (das betrifft aber nur Produkte gemäß Anhang III: u. a. Bildung, HR)

- von der Entscheidung betroffenen Personen Auskunft erteilen (Artikel 86) (das betrifft aber nur Produkte gemäß Anhang III)

2.3 Anforderungen an Betreiber „bestimmter KI-Systeme“

Der Artikel 50 legt für mehrere Typen von KI-Systemen Anforderungen fest:

| Typ: KI-Systeme, die | Anforderung |

| direkt mit natürlichen Personen interagieren | Keine Betreiberpflichten (Anbieter müssen Systeme so konzipieren, dass die Personen darüber informiert sind) |

| der Emotionserkennung dienen | u. a. Datenschutz einhalten |

| der Bild-, Ton-, Text- oder Videomanipulation dienen | Deepfakes bzw. Manipulation offenlegen |

3. Antworten

3.1 Weitgehende Entwarnung

In erster Näherung sind Hersteller, welche keine KI-Systeme herstellen, aber KI-Systeme verwenden und damit betreiben, abgesehen von den Kompetenzanforderungen vom AI-Act nicht betroffen.

Beispielsweise regelt der AI Act die Nutzung(!) von LLMs à la ChatGPT nicht. Auch darf KI im Rahmen von QM-Prozessen verwendet werden, z. B. um Prozesse zu automatisieren oder zu optimieren (z. B. Chatbox für die Kundenkommunikation) oder die Konformität von Produkten oder Prozessen zu prüfen.

3.2 Ausnahmen von der Entwarnung

Es gibt allerdings Ausnahmen.

- Dazu zählen Hochrisiko-KI-Systeme, insbesondere die Systeme gemäß Anhang III. Das dürften bei Medizinprodukteherstellern Systeme im HR-Kontext sein, v. a. für die (Weiter-)Bildung und für Personalentscheidungen. Ob der Hersteller diese Systeme selbst entwickelt hat oder von Dritten entwickelte Systeme verwendet, ist irrelevant.

- Falls Hersteller ihre Medizinprodukte bzw. IVD selbst betreiben, zählen sie ebenfalls als Betreiber von Hochrisiko-Systemen. Ein Beispiel wäre ein Hersteller, der den Server für eine Mobile Medical App betreibt, auf dem KI-Algorithmen laufen und der ein Medizinprodukt oder Teil eines solchen ist.

3.3 Medizinprodukterecht beachten

Anforderungen aus dem Medizinprodukte-Recht (z. B. MDR, IVDR, ISO 13485) gelten unabhängig davon. Beispielsweise sollten die Hersteller die Anforderungen an die Computerized Systems Validation beachten, falls sie ein KI-System im Rahmen von QM-Prozessen einsetzen.

Das Johner Institut unterstützt sowohl Hersteller als auch Betreiber dabei, die Anforderungen des AI Act zu erfüllen. Mögliche Hilfestellungen sind

- eine Bewertung, welche regulatorischen Anforderungen für das jeweilige Unternehmen gelten,

- Projektpläne,

- Templates für SOPs, Arbeitsanweisungen und Aufzeichnungen,

- Qualifizierung der verantwortlichen Personen und

- Tipps zum Vermeiden unnötiger Aufwände.